Hackathon Opendatasoft : explorer le potentiel de l’Intelligence Artificielle dans les outils de gestion des données

Opendatasoft a organisé un hackathon interne réunissant plus de 30 développeurs et développeuses pour tester plusieurs idées d’amélioration de notre plateforme grâce à l’Intelligence Artificielle (IA). Retrouvez tous les enseignements de ces deux journées d’émulation dans cet article.

L’Intelligence Artificielle et le Machine Learning font leur apparition dans de nombreuses technologies et bouleversent les processus en place en termes d’efficacité et de rapidité dans l’accomplissement de nombreuses tâches.

Quels bénéfices ces technologies pourraient-elle apporter aux utilisateurs de logiciels SaaS de data management ?

Opendatasoft a organisé un hackathon interne réunissant plus de 30 développeurs et développeuses pour tester plusieurs idées d’amélioration de notre plateforme grâce à l’Intelligence Artificielle (IA). Retrouvez tous les enseignements de ces deux journées d’émulation dans cet article.

Intelligence Artificielle : une révolution pour les plateformes SaaS de data management ?

Quand on parle d’Intelligence Artificielle (IA) et de Machine Learning, on pense souvent aux volumes de données considérables qui viennent alimenter ces modèles.

Mais l’Intelligence Artificielle et le Machine Learning peuvent aussi aider à automatiser de nombreux processus manuels et répétitifs, ce qui permet aux collaborateurs de se concentrer sur des tâches à forte valeur ajoutée. De plus en plus, les organisations y ont recours pour améliorer leurs processus et gagner en efficacité.

Chaque organisation ayant un niveau de maturité différent sur le sujet de l’IA, tout l’enjeu de ces technologies réside dans leur démocratisation.

Un hackathon pour explorer les bénéfices de l’Intelligence Artificielle pour la plateforme Opendatasoft

Opendatasoft propose une solution SaaS qui occupe une place centrale dans la stratégie data des organisations. C’est pourquoi nos équipes s’intéressent particulièrement aux capacités de l’Intelligence Artificielle et du Machine Learning pour aider à accélérer les démarches de valorisation et de démocratisation des données de nos clients.

Pour concrétiser cet engagement, nous avons organisé un hackathon dédié à la question de l’Intelligence Artificielle. L’objectif : travailler sur une ou plusieurs fonctionnalités permettant d’enrichir notre plateforme dans un délai très court.

Les 4 et 5 juillet 2023, plus de 30 développeurs et développeuses de nos équipes Infrastructure, Sécurité, Engineering et Customer Services se sont donc réunis pour tester plus de 10 idées d’enrichissement de notre solution grâce à l’IA.

Ces deux journées d’émulation ont permis d’atteindre plusieurs objectifs :

Inspirer les Product Managers

Le premier objectif de ces deux journées de hackathon était bien évidemment d’inspirer les Product Managers en charge des prochaines évolutions de la solution.

L’intelligence Artificielle étant un domaine complexe et encore méconnu, il était nécessaire de tester plusieurs hypothèses afin d’identifier des opportunités d’amélioration. Ces tests ont permis aux équipes techniques de prendre conscience de plusieurs enjeux :

- La difficulté de développement de certaine fonctionnalités

- Les risques de sécurité liés à l’IA

- La pertinence ou la plus value d’une fonctionnalité pour nos utilisateurs

À l’issue de cette rencontre, les participants ont présenté aux Product Manager les différentes pistes explorées et les enseignements retenus.

L’intelligence Artificielle ne faisait pas partie de notre “boîte à outils” lors de la conception d'une fonctionnalité. Grâce à ce hackathon, nous avons pu utiliser l’IA pour améliorer plusieurs fonctionnalités afin de valider ou d’invalider certaines hypothèses. Nous pouvons déjà imaginer les bénéfices que pourrait apporter cette démarche à nos utilisateurs.

Mieux comprendre les problématiques liées à l’Intelligence Artificielle

Chez Opendatasoft, nous partageons la conviction que l’Intelligence Artificielle peut permettre d’automatiser un certain nombre de tâches réalisées par nos clients. Mais la discipline soulève de nombreuses questions liées à la sécurité et aux compétences nécessaires.

Ce hackathon était donc l’occasion d’approfondir les connaissances des équipes sur le sujet. Notamment via l’utilisation d’APIs prêtes à l’emploi (comme celles d’OpenAI), de modèles LLM locaux ou de librairies ML classiques (comme Tensorflow).

Certains membres de l’équipe avaient déjà travaillé sur des Intelligences Artificielles dans leurs expériences précédentes, mais nous n’avions jamais initié de réel projet en interne sur ce sujet. Ce hackathon nous a permis d’expérimenter les technologies de l'IA et de développer une expertise sur leur utilisation afin d'en faire un outil pour les futures orientations produit.

Faire monter les équipes en compétence et renforcer la cohésion

Enfin, ce hackathon avait pour objectif de faire monter en compétence les équipes de développeurs. Les équipes ont été complètement mélangées et les collaborateurs ont pu travailler avec de nouveaux collègues sur une courte période de temps ce qui a déclenché de nouvelles réflexions.

Les équipes ont ainsi pu échanger leurs meilleures pratiques et s’entraider pour appréhender la question difficile de l’Intelligence Artificielle.

Le périmètre des fonctions que propose la plateforme Opendatasoft est très large. Le quotidien de développement assez chargé laisse parfois peu de place à l'expérimentation et aux échanges inter-équipes. Le hackathon vient pallier ce problème : pendant 2 jours, on mélange les équipes et on expérimente les dernières tendances technologiques (en l'occurrence : l'IA). Et le résultat est au rendez-vous : de nouveaux liens entre collègues ont été créés et de nouveaux projets innovants ont vu le jour !

Quelles pistes pour améliorer la plateforme Opendatasoft grâce à l’IA ?

En amont du hackathon, les équipes ont réuni plus de 30 idées d’améliorations à tester. Elles provenaient des équipes Techniques et Produit elles-mêmes, mais également des discussions avec nos clients.

Chaque participant était libre de choisir le sujet sur lequel il souhaitait travailler lors du hackathon et les groupes étaient constitués de 2 à 6 personnes. Plusieurs projets ont été retenus :

Pré-générer automatiquement une configuration complète du schéma d’un jeu de données (types, facettes) afin de faire gagner un temps considérable aux responsables de la publication et améliorer la qualité des données publiées.

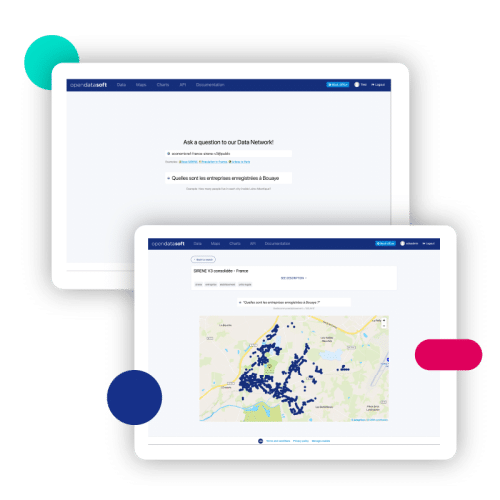

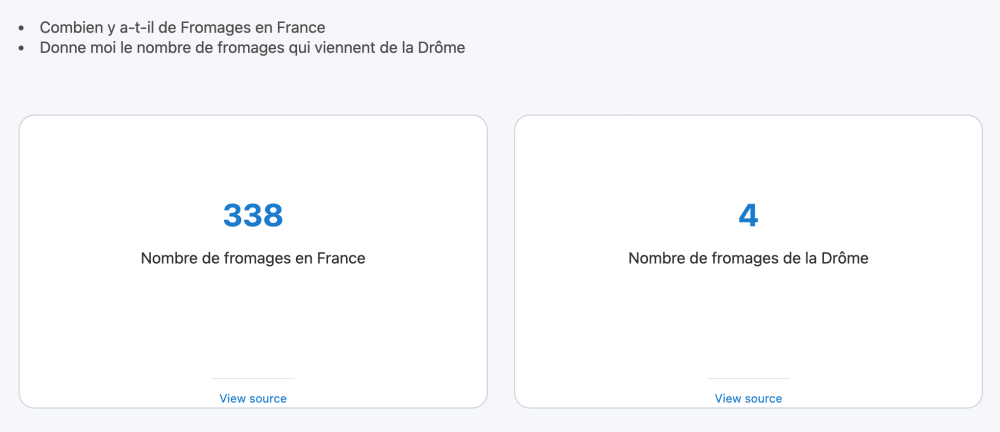

Traduire automatiquement des requêtes en langage naturel en requêtes d’APIs Explore afin de permettre aux consommateurs de données d’interroger les données en posant de simples questions, sans avoir à comprendre le langage de requête ODSQL.

Ajouter un module de recommandation de datasets basé sur les similarités sémantiques des métadonnées des datasets d’un portail.

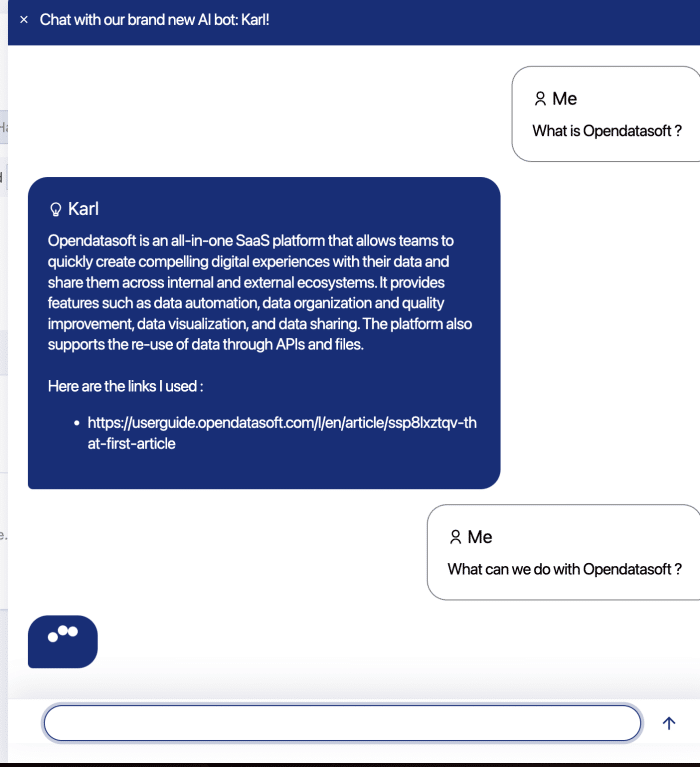

Permettre aux utilisateurs d’Opendatasoft de poser des questions spécifiques sur le produit et son utilisation en utilisant un modèle local de langage étendu formé avec nos différentes documentations.

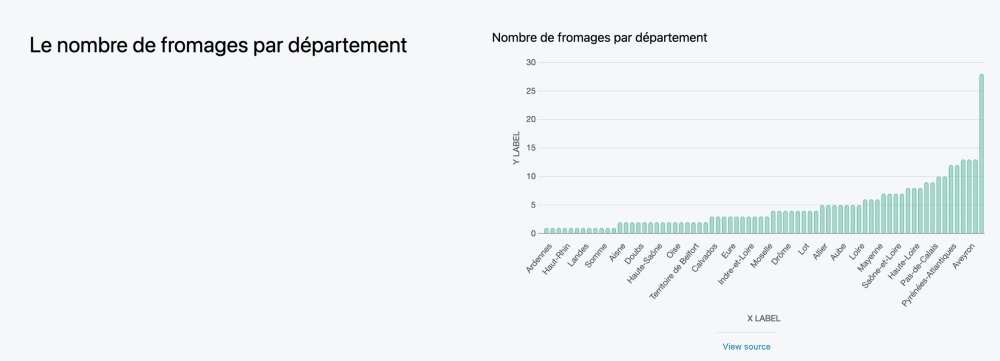

Générer automatiquement des blocs de data visualisation dans le Studio Opendatasoft à partir d’une demande en langage naturel. Par exemple : “Je veux afficher le dataset des arbres remarquables sur une carte de Paris pour voir combien d’arbres il y a dans chaque arrondissement. ».

Améliorer la recherche sur les portails de données en utilisant les capacités de recherche vectorielle d’Elasticsearch et en améliorant la recherche sur les métadonnées et les jeux de données.

Pour chaque projet, les différentes équipes ont proposé des pistes de recherche et ont fait la démonstration des résultats obtenus au reste des collaborateurs.

Quels enseignements retenir ?

Au-delà des apprentissages réalisés sur notre plateforme, nous pouvons tirer des conclusions globales sur l’utilisation de l’Intelligence Artificielle appliquée à notre solution. Chaque équipe a pu d’une manière ou d’une autre constater les mêmes avantages et inconvénients :

- L’Intelligence Artificielle ouvre de nouvelles perspectives : l’IA donne des résultats impressionnants dans des délais très courts. Les équipes ont pu imaginer des interfaces simples qui contribuent à démocratiser la data. C’est une première conclusion très encourageante pour les prochaines innovations produit que nous souhaitons proposer.

- L’IA n’est pas toujours fiable : si 90% des tests réalisés fonctionnent parfaitement, 10% d’entre eux ne répondent pas à l’objectif de départ. Par ailleurs, certains tests effectués n’ont pas été concluants car les données disponibles n’étaient pas suffisamment qualitatives.

- L’Intelligence Artificielle vient avec son lot de contraintes : du modèle économique en passant par la question de la confidentialité, de la sécurité et de la souveraineté des données. Il est possible d’aller très vite pour créer de nouvelles fonctionnalités. Mais pour répondre aux attentes de nos clients, cela demandera un temps plus long afin de développer des modèles qui nous permettront d’avoir un contrôle total sur la sécurité et la qualité des données.

Les équipes se sont surpassées durant ces deux journées et nous avons été très agréablement surpris par les découvertes que nous avons faites ! Bien sûr, l’IA reste un sujet complexe à maîtriser qui nécessite un investissement sur le long terme. Mais le jeu en vaut la chandelle et le potentiel de cette approche est très important, que ce soit pour l’amélioration de fonctionnalités existantes ou le développement de nouvelles fonctionnalités disruptives.

Accès aux données

Accès aux données

Mettre en place un data catalog, c’est poser les fondations de sa stratégie data : recenser, structurer, qualifier les actifs. Un chantier souvent long, parfois technique, toujours ambitieux. Pourtant, dans bien des organisations, une question persiste : comment faire en sorte que ces données soient réellement utilisées à grande échelle ?

Pour partager les données à grande échelle, les Chief Data Officers doivent mettre en place les compétences, ressources et structures adéquates. Sur la base d’une nouvelle étude de Gartner, voici comment constituer des équipes data efficaces, capables de répondre à la fois aux besoins des équipes métier et de l’entreprise au sens large.

Pour entraîner et déployer des algorithmes et agents d’IA, des données de qualité sont essentielles. Découvrez dans cet article comment partager efficacement des données prêtes à l’emploi et lisibles par la machine grâce aux data products et marketplaces.